2025. 4. 1. 22:00ㆍ데이터 엔지니어링 위클리

Articles

왼쪽과 오른쪽으로 이동하기

이 글에서는 데이터 엔지니어링의 변화와 미래 방향성을 다루고 있습니다. 특히, 데이터 엔지니어들이 '왼쪽으로 이동'하는 것뿐만 아니라, '오른쪽으로 이동'하는 경향도 있으며, 이는 데이터 품질 개선과 고객 가치 창출을 목표로 하는 새로운 데이터 작업 방식의 융합을 의미합니다.

- 데이터 엔지니어들은 이제 더 이상 내부 IT 비용 센터로 한정되지 않고, 고객 가치 실현을 위해 다양한 역할을 수행해야 합니다.

- DataOps와 Data Mesh와 같은 혁신적인 개념들이 데이터 엔지니어링의 변화를 촉발하고 있습니다.

- 데이터 엔지니어와 소프트웨어 엔지니어 간의 경계가 허물어지고 있으며, 데이터와 AI의 통합적 접근이 요구됩니다.

개요

이 글에서 Joe Reis는 데이터 엔지니어링의 최근 변화에 대해 논의합니다. 그는 데이터 팀이 전통적으로 단순한 IT 비용 센터로 남아있는 대신, 비즈니스 가치 창출과 관련되어야 한다고 주장합니다. 이를 위해 'Shift Left'와 'Shift Right'라는 두 개념을 도입하여 데이터 엔지니어와 소스 시스템, 사용자 간의 관계가 변화하고 있음을 설명합니다. 'Shift Left'는 데이터 품질 향상과 비즈니스 목표의 일치를 강조하며, 데이터 팀이 생산자(소스 시스템)와 소비자(최종 고객) 간의 가치 창출을 위해 구조적, 문화적으로 정렬되어야 한다는 것을 의미합니다. 'Shift Right'는 데이터 엔지니어들이 더 많은 머신러닝(ML)/인공지능(AI) 작업에 참여하게 됨을 나타냅니다.

Shift Left와 Shift Right의 의미

- Shift Left: 데이터 팀이 비즈니스 목표를 이해하고, 고객 만족을 위해 데이터 품질을 향상시키는 방향으로 나아가는 과정을 의미합니다. 데이터Ops, 데이터 메시, 데이터 계약 등 여러 개념이 이 변화를 주도하고 있습니다.

- Shift Right: 데이터 엔지니어들이 머신러닝과 인공지능 작업에 더 많이 참여하게 되는 경향을 설명합니다. 이는 데이터 엔지니어와 소프트웨어 엔지니어 간의 경계가 흐려지고 있는 것을 나타냅니다.

데이터 엔지니어링 생태계의 통합

Joe는 이러한 변화가 데이터 엔지니어, 소프트웨어 엔지니어, 그리고 머신러닝 엔지니어 간의 경계를 모호하게 만들고 있음을 지적합니다. 이 과정을 'The Convergence'라고 부르며, 데이터와 AI가 결합하여 인간과 기계가 협력해 제품과 서비스를 제공하는 형태로 나아가고 있음을 강조합니다.

결론

결국 Joe는 데이터 엔지니어링의 향후 방향이 이전의 단순한 역할에서 벗어나, 다양한 분야의 통합으로 나아가고 있음을 강조합니다. 이러한 변화는 데이터 엔지니어들이 더 다양한 역할을 수행하게 할 것이며, 비즈니스 가치 창출에 기여하는 방식으로 나아갈 것임을 시사합니다.

Joe Reis

The Convergence - Shifting Left AND Right

Karpenter 트러블슈팅 - 비용과 안정성 두 마리 토끼 잡기

이 글은 당근페이의 Site Reliability Engineer인 Yany가 Karpenter를 도입하여 인프라 비용을 최적화하고 안정성을 높이기 위해 겪었던 경험과 트러블슈팅 과정을 상세히 공유하는 내용입니다. Karpenter의 작동 원리와 이점, 도입 과정에서 마주한 문제들을 해결하기 위한 노력을 설명하며, 이를 통해 얻은 긍정적인 효과 및 앞으로의 개선점도 다루고 있습니다.

- Karpenter는 쿠버네티스 클러스터에서 파드 수요에 맞춰 자동으로 노드를 조절하는 도구입니다.

- Karpenter 도입 이전의 문제점으로는 비용 낭비와 스케줄링 이슈가 있었습니다.

- 트러블슈팅 과정에서 스케줄링의 안정성 및 리소스 최적화에 대한 여러 도전 과제들이 있었습니다.

- 도입 후 월간 인프라 비용을 약 10,000달러 절감하는 성과를 달성하였습니다.

- 향후 개선점으로는 노드 웜업 시간 및 스케줄링 정합성을 향상시키기 위한 노력이 필요합니다.

개요

이 글은 당근페이의 인프라팀에서 Karpenter를 도입하여 효율적인 클러스터 스케일링을 구현하는 과정에서의 경험담과 문제 해결 과정을 다루고 있습니다. Karpenter는 쿠버네티스 클러스터에서 자동으로 노드를 관리하는 도구로, 기존의 인프라 운영 방식에서 발생하는 다양한 문제점을 해결하기 위한 노력의 일환으로 채택되었습니다. 문서에서는 Karpenter의 기능과 장점, 도입 후 발생한 문제 및 해결 방안에 대한 구체적인 내용이 소개됩니다.

Karpenter 개요

Karpenter는 클러스터의 파드 수요에 따라 노드의 양을 조절하는 Cluster Autoscaling Operator입니다. 이를 통해 필요한 노드를 자동으로 생성하고 관리할 수 있으며, 주요 기능으로는 파드 스케줄링 지원, 자원 최적화, 노드 생명주기 관리 등을 포함합니다. 이를 활용하여 비용을 절감하고 인프라 효율성을 높이는 것이 목표입니다.

도입 배경과 문제점

당근페이는 ASG(AWS EC2 AutoScaling Group) 시스템을 사용하고 있었으나, 이는 여러 병목 현상, 관리 포인트 증가, 자원 낭비 등의 문제를 발생시켰습니다. 특히 거래량과 사용자 수의 급격한 증가로 인해 기존 인프라의 한계가 드러나 Karpenter로의 전환이 필요하다고 판단하게 되었습니다.

트러블슈팅 과정

Karpenter를 도입한 후 겪은 주요 문제와 그에 대한 해결 과정을 다루고 있습니다.

- 스케줄링 이슈: 초기에는 일부 파드가 Pending 상태로 남아있어, 이를 해결하기 위한 스케줄링 로직을 분석하였습니다.

- AMI 사용 제약: 커스텀 AMI를 사용하는 과정에서 발생하는 제약사항으로 인해 추가 리소스가 소요되었습니다.

- 노드 크기 관리: Karpenter가 생성하는 노드 크기에 대한 변화가 DaemonSet 비용에 영향을 미쳐 최적화가 필요했습니다.

- 리소스 인식 차이: Karpenter에서 감지한 리소스 양과 실제 리소스 양의 차이로 인해 안정성이 떨어지는 문제가 발생했습니다.

- Node Churn 현상: 여러 노드가 동시에 생성 및 삭제되는 현상이 계속 발생하여 문제 해결을 위해 budget 설정을 조정하였습니다.

결론

Karpenter 도입을 통해 월간 인프라 비용을 약 10,000달러 절감할 수 있었으며, 엘라스틱 클러스터 관리를 더 효율적으로 수행할 수 있는 기반을 마련했습니다. 그러나 여전히 해결해야 할 문제들이 존재하며, 노드 웜업 시간 개선, 레이턴시 안정화, 스케줄링 정합성 향상 등의 과제가 남아 있습니다. 이를 통해 더욱 효율적이고 안정적인 인프라를 구축하기 위한 노력은 계속될 것입니다.

당근마켓 팀블로그

Karpenter 트러블슈팅 - 비용과 안정성 두마리 토끼 잡기

에어비앤비가 숙소 평생 가치를 측정하는 방법

Airbnb의 블로그 글에서는 호스트들이 게스트에게 더 많은 가치를 제공할 수 있도록 오프라인 숙소의 생애 가치를 측정하는 방법에 대해 다룹니다. 글에서는 생애 가치 측정의 세 가지 주요 요소인 기본 생애 가치, 증분 생애 가치, 마케팅 유도 증분 생애 가치를 설명하며, 이러한 프레임워크를 실제로 적용하는 과정에서 마주친 여러 도전 과제에 대해서도 언급합니다.

- Airbnb는 생애 가치를 통해 숙소 리스트를 세분화하고 가장 게스트에게 매력적인 숙소를 파악합니다.

- 증분 생애 가치는 새로운 리스트의 참여로 인해 추가적으로 발생한 거래를 측정하는 데 중점을 둡니다.

- COVID-19와 같은 외부 요인의 변화로 인해 예측값을 지속적으로 업데이트하며 정확성을 향상시키는 방법을 논의합니다.

개요

이 글에서는 Airbnb가 숙소의 평생 가치를 측정하는 방법에 대해 설명하고 있습니다. Airbnb는 손님에게 제공하는 최고의 경험을 위해 어떤 숙소가 가치를 지니는지를 이해하는 것이 중요하다고 강조합니다. 이를 위해 숙소의 생애 주기 가치(Lifetime Value, LTV)를 추정하는 프레임워크를 구축하였으며, 이를 통하여 손님에게 가장 매력적인 숙소의 유형을 파악하고 호스트에게 추가적인 자원과 추천을 개발하는 데 도움을 줍니다.

Listing Lifetime Value 프레임워크

Airbnb의 LTV 프레임워크는 세 가지 주요 요소로 구성됩니다: - 기본 LTV: 특정 숙소가 향후 365일 동안 Airbnb에서 얼마나 많은 예약을 받을 것으로 예상되는지를 측정합니다. 이 과정에서 기계 학습을 활용하여 각 숙소에 대한 데이터를 분석합니다. - 증분 LTV: 새로운 숙소가 기존 숙소의 예약을 잠식(cannibalization)하는 것도 고려하여, 새로운 숙소가 추가한 가치를 측정하는 방식입니다. 증분 LTV는 기본 LTV에서 자신의 예약이 줄어드는 양을 빼는 방법으로 도출됩니다. - 마케팅 유도 증분 LTV: 마케팅 캠페인 등의 내부 이니셔티브로 인해 생성된 추가 가치를 측정합니다. 예를 들어, 호스트에게 무엇을 개선해야 하는지에 대한 정보 제공을 통해 예약이 증가한다면, 이 증가분을 측정합니다.

측정의 도전 과제

Airbnb는 LTV를 측정하는 데 있어 몇 가지 중요한 도전에 직면합니다: 1. 기본 LTV의 정확한 측정: 초기 데이터 수집 후 365일이 지나야 예약 수를 관측할 수 있으며, 이 기간 동안 발생하는 시장 변화는 예측의 정확도에 영향을 미칠 수 있습니다. 2. 증분성을 측정하기: 각 예약이 증분인지 아니면 다른 숙소에서 잠식된 것인지를 정확히 파악하기 어렵습니다. 이러한 이유로, Airbnb는 과거의 공급과 수요 데이터를 바탕으로 생산 함수를 모델링하여 증분성을 추정합니다. 3. 불확실성 처리: 예를 들어, COVID-19 동안 여행 패턴이 급격하게 변한 경우, 초기 예측에 따라 조정이 필요합니다. Airbnb는 예약 발생 수를 기반으로 지속적으로 예측치를 업데이트하여 이 문제를 해결합니다.

결론

Airbnb의 숙소 생애 주기 가치는 커뮤니티에 더 나은 서비스를 제공하는 데 필수적입니다. 이 글에서는 Airbnb의 LTV 측정 프레임워크에 대해 설명하고 있으며, COVID-19와 같은 외부 충격이 예측에 미치는 영향을 다룹니다. Airbnb는 이 모델을 통해 유망한 숙소 세그먼트를 파악하고, 어떤 위치에서 호스트가 더 많은 예약을 받을 수 있는지, 내부 마케팅 이니셔티브가 커뮤니티에 얼마나 많은 가치를 제공하는지를 식별할 수 있습니다. 또한, 이 평가 프레임워크는 향후 Airbnb Experiences와 같은 다른 분야에도 확장될 수 있는 가능성이 있습니다.

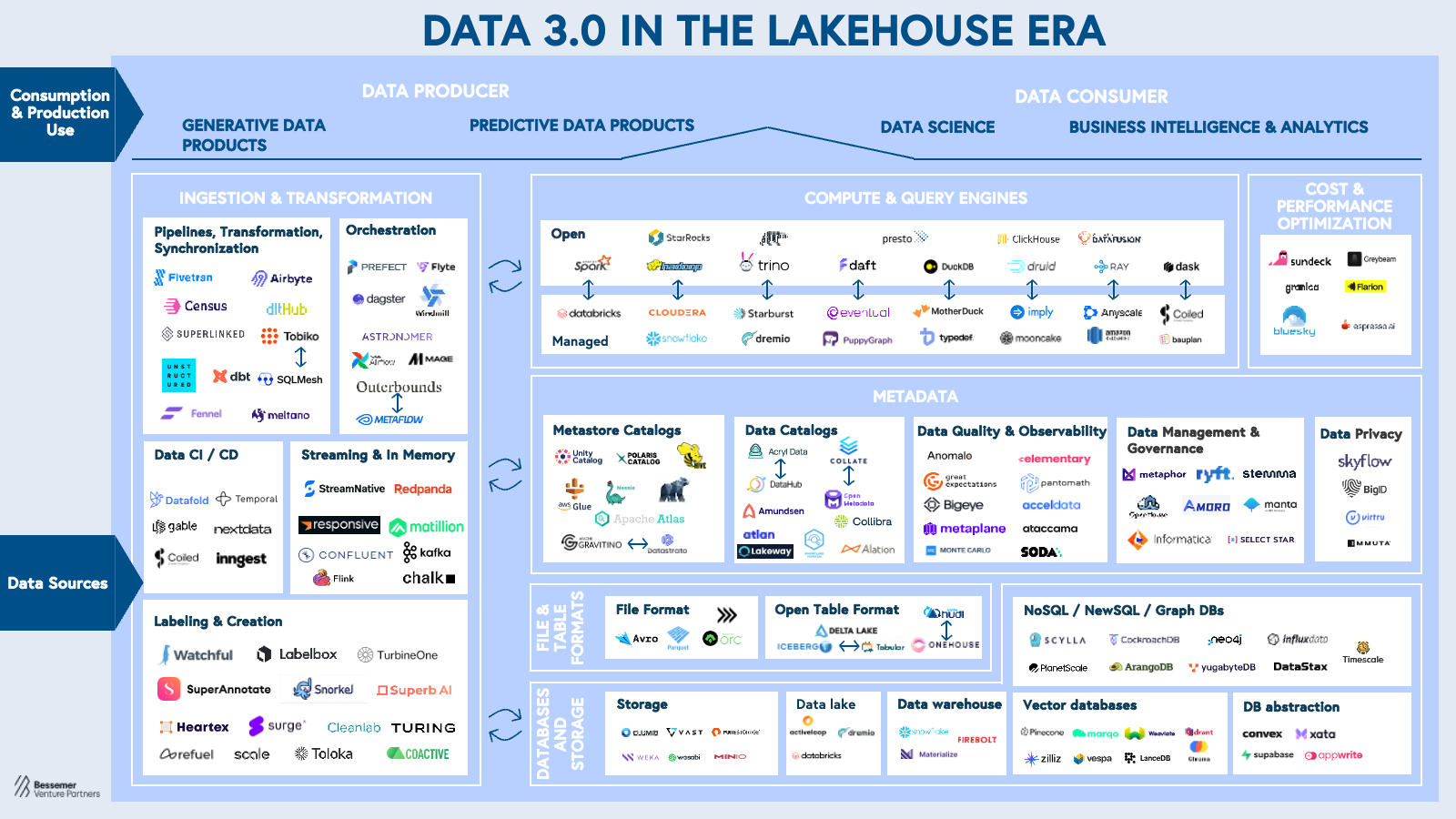

로드맵: 레이크하우스 시대의 데이터 3.0

이 블로그 글은 "Data 3.0" 시대의 데이터 인프라 로드맵을 다루며, 특히 레이크하우스(Lakehouse) 아키텍처가 AI 시대의 핵심 인프라로 떠오르고 있다는 점을 강조합니다. 기존의 클라우드 데이터 웨어하우스와 데이터 레이크의 한계를 극복하고, 분석 및 AI 워크로드를 아우르는 통합형, 상호운용 가능한 플랫폼으로 레이크하우스가 부상하고 있다는 것이 핵심입니다.

- 레이크하우스는 AI 분석까지 가능한 차세대 데이터 인프라로, 다양한 데이터 유형(정형/비정형)을 하나의 플랫폼에서 처리 가능

- AI의 급부상으로 실시간/멀티모달 데이터 처리 요구가 증가하며, 기존 인프라로는 한계 발생

- 메타데이터 계층, 컴퓨트 엔진, 파이프라인, 개발 방식까지 데이터 인프라 전반에 구조적 변화 발생

패러다임의 변화: Data 1.0 → 2.0 → 3.0

- 과거: 온프레미스 → 클라우드 데이터 웨어하우스 → 데이터 레이크

- 현재: AI 시대의 도래와 함께 레이크하우스(Lakehouse) 중심의 Data 3.0 시대로 전환 중

- 레이크하우스란? 데이터 웨어하우스의 정형화된 처리 + 데이터 레이크의 유연함을 결합한 차세대 아키텍처로, 다양한 데이터 타입(AI용 비정형 포함)을 하나의 플랫폼에서 고성능으로 처리

AI 시대의 요구사항이 데이터 인프라를 재정의

- AI 확산으로 인해 데이터 아키텍처의 확장성, 성능, 실시간성, 거버넌스에 대한 요구가 급증

- 기존 아키텍처(웨어하우스, 레이크)는 한계 노출

- 비정형 데이터 활용 부족

- 데이터 복제/중복으로 인한 비용 문제

- 실시간/멀티모달 처리 미흡

- 벤더 락인(vendor lock-in) 문제 증가

레이크하우스를 가능케 한 핵심 기술: Open Table Formats (OTFs)

- Delta Lake, Iceberg, Hudi 등은 파일 기반 데이터를 테이블처럼 다룰 수 있게 해 줌

- 지원 기능:

- ACID 트랜잭션

- 스트리밍+배치 통합

- 스키마 진화

- 타임 트래블

- 메타데이터 확장

- 오픈 스탠다드의 발전이 상호운용성(interoperability)을 폭발적으로 향상

Data 3.0 시대의 4가지 핵심 명제(Thesis)

1️⃣ AI-Native 파이프라인: 실시간·코드 기반 데이터 처리- 기존 ETL 툴은 AI 환경에 비효율적(배치성이기 때문)

- Prefect, dltHub 등 코드 네이티브 툴이 부상

- 실시간 추론 위해 Kafka, Flink, Chalk AI 등이 스트리밍 퍼스트 아키텍처로 진화

- 메타데이터가 단순 반영(reflection)이 아니라 진짜 소스(source)

- Data Catalogs와 Governance가 핵심 도구로 부상 (예: Datastrato, Acryl Data)

- 메타데이터는 최적화·버전 관리·거버넌스를 가능하게 하는 컨트롤 플레인으로 진화 중

- Snowflake, Databricks 주도하던 시장에 DuckDB, ClickHouse, Daft 등 신흥 솔루션 등장

- AI 워크로드 최적화 위한 Iceberg 네이티브 컴퓨트 플랫폼 등장 (Mooncake, Bauplan 등)

- 배치+스트리밍의 공존 및 AI 최적화된 쿼리 엔진이 핵심 트렌드

- AI 애플리케이션의 복잡성과 실시간 요구가 풀스택형 AI 엔지니어 수요 증가로 연결

- dbt Labs, Temporal 등은 소프트웨어 개발 방식을 데이터 세계에 접목

- 오픈소스 채택 확대, LLM 친화성이 기술 선택에 중요한 요소로 작용

결론

Data 3.0은 단순한 업그레이드가 아닌, AI 시대에 맞춘 데이터 인프라의 근본적 재설계입니다.

레이크하우스를 중심으로 개방형 생태계, 상호운용성, 실시간성, AI 네이티브 아키텍처가 대세가 되며,

차세대 유니콘 기업 탄생의 기회로 부상하고 있습니다.

The Airbnb Tech Blog

How Airbnb Measures Listing Lifetime Value

Jobs

원티드 채용공고(최근 7일)

- 미리디 - 데이터 엔지니어

- 에스케이렌터카(SK렌터카) - Data Engineer (데이터 엔지니어)

- 엘리오앤컴퍼니 - 헬스케어 시스템 개발자(DB개발자)

- 키다리스튜디오 - [레진코믹스] 데이터 엔지니어

- 인포유앤컴퍼니 - SQL 개발자

- 엘박스 - Data Engineer

- 바이오리서치에이아이 - 데이터엔지니어

- 퀀팃 - 금융 데이터 Ops 엔지니어

- 브레이브모바일(숨고,Soomgo) - Data Engineer

- 우아한형제들(배달의민족) - [Tech] 스토리지서비스팀 데이터베이스엔지니어

- 그래픽 - Software Engineer (Test Automation,ETL,Python)

- 한경에이셀 - 데이터 사이언스 엔지니어 (Data Science Engineer)

- 업스테이지 - Senior Data Engineer - LLM

- 라플라스테크놀로지스 - 데이터 엔지니어 (Forward Deployed Data Engineer)

- 무신사 - Data Engineering Manager (데이터플랫폼)

- 넷마블 - 데이터 엔지니어

- 딥세일즈 - 데이터 엔지니어 (5년 이상)

필요한 기술(최근 7일)

주요 업무(최근 7일)

필요한 소프트 스킬(최근 7일)

필요한 경험(최근 7일)

'데이터 엔지니어링 위클리' 카테고리의 다른 글

| 데이터 엔지니어링 위클리 #8 | Hadoop, Netflix Maestro, Senior Data Engineer (0) | 2025.04.23 |

|---|---|

| 데이터 엔지니어링 위클리 #6 | Knowledge Graph, Data Observability, OpenTelemetry, OpenLineage (0) | 2025.04.08 |

| 데이터 엔지니어링 위클리 #4 | LLM, AI, Netflix, Airbnb (0) | 2025.03.26 |

| 데이터 엔지니어링 위클리 #3 | 스파크 최적화, 데이터 제품, Late-Arriving Data (0) | 2025.03.19 |

| 데이터 엔지니어링 위클리 #2 | Data Lineage, SQLMesh, DBT, Synthetic Data (0) | 2025.03.11 |