2025. 3. 19. 00:21ㆍ데이터 엔지니어링 위클리

Articles

⭐️ 페이스북의 수십억 개 메시지를 처리하는 Apache Cassandra 심층 분석

이 글은 페이스북이 빌리언 단위의 메시지를 관리하기 위해 개발한 분산 데이터베이스 시스템인 아파치 카산드라(Apache Cassandra)에 대해 심도 있는 분석을 제공합니다. 카산드라의 구조와 작동 원리, 특히 데이터 저장 및 검색 방식에 대한 기술적인 특징을 상세히 설명하며 이를 통해 대규모 데이터 처리의 효율성을 강조하고 있습니다.

- 아파치 카산드라는 분산 스토리지 방식으로 설계되어 있으며, 데이터의 고가용성과 내구성을 보장합니다.

- 페이스북의 인박스 검색 기능을 지원하기 위해 특별히 고안되었으며, 수많은 메시지를 빠르게 검색할 수 있는 구조를 갖추고 있습니다.

- 데이터 모델은 전통적인 관계형 데이터베이스와는 달리 다차원 맵과 유사한 구조로 설계되어 있습니다.

개요

이 글에서는 페이스북이 직접 개발한 데이터베이스 시스템인 Apache Cassandra®에 대해 깊이 있게 설명하고 있습니다. Apache Cassandra®는 대량의 데이터를 효과적으로 저장하고 처리할 수 있도록 설계된 분산형 데이터베이스 시스템으로, 매일 수십억 개의 메시지를 처리하는 페이스북의 필요에 맞춰 개발되었습니다. 전통적인 관계형 데이터베이스가 가지는 한계를 극복하기 위해 아마존의 Dynamo와 구글의 Bigtable에서 영감을 받아 만들어졌으며, 그로 인해 분산 저장, 높은 가용성, 확장성 등의 특징을 갖추게 되었습니다.

Apache Cassandra®의 주요 특징

- 분산 저장: 데이터가 여러 기계에 분산되어 저장됩니다.

- 높은 가용성: 일부 기계가 고장 나더라도 시스템이 계속 작동합니다.

- 단일 실패 지점 없음: 모든 노드가 동등하게 작동하므로, 중앙 집중형 서버의 실패로 인한 문제를 피할 수 있습니다.

- 확장성: 더 많은 기계를 네트워크에 추가함으로써 용량을 쉽게 확장할 수 있습니다.

데이터 모델과 아키텍처

Apache Cassandra®는 데이터가 다차원 맵 형태로 저장되는 데이터 모델을 제공합니다. 데이터는 열 패밀리(column family)로 조직되며, 단순 열 패밀리와 슈퍼 열 패밀리로 나뉩니다. 이와 함께 API를 통해 데이터를 삽입, 조회, 삭제하는 기본 작업이 이루어지며 각 작업은 고유한 키를 중심으로 실행됩니다.

데이터 읽기와 쓰기 과정

쓰기 과정에서 데이터는 먼저 커밋 로그(commit log)에 기록된 후, 메모리의 메모리 테이블(memtable)에 임시 저장됩니다. 이후 이 데이터는 일정 크기에 도달하면 SSTable이라는 형태로 디스크에 저장됩니다. 읽기 과정에서는 먼저 메모리 테이블에서 데이터를 찾고, 없을 경우 SSTable에서 찾는 구조입니다. 이때 블룸 필터(bloom filter)를 활용하여 검색 속도를 최적화합니다.

Bloom filters는 집합 내에 특정 원소가 존재하는지를 확인할 때 사용되는 자료구조입니다.

페이스북의 인박스 검색 사용 사례

Apache Cassandra®는 페이스북의 인박스 검색 기능을 구현하기 위해 사용되었습니다. 페이스북은 MySQL을 사용하여 데이터를 저장했으나 사용자가 늘어나자 성능이 떨어졌습니다. 이를 해결하기 위해 150개의 노드로 구성된 클러스터를 구축하여 50TB를 저장하고, 다양한 검색 쿼리를 지원하여 신속한 시급성을 발휘했습니다.

결론

Apache Cassandra®는 대규모 데이터 처리와 고가용성이 필요한 애플리케이션에 매우 적합한 솔루션입니다. 분산형 아키텍처와 높은 쓰기 효율성 덕분에 실시간 애플리케이션에 적합합니다. 그러나 복잡한 쿼리와 트랜잭션 일관성을 요구하는 경우 전통적인 관계형 데이터베이스를 대체할 수 없으므로 각 기능에 맞는 적절한 데이터베이스 선택이 필요합니다.

ByteByteGo Newsletter

Facebook’s Database Handling Billions of Messages (Apache Cassandra® Deep Dive)

⭐️ 데이터 제품 테스트 전략: 핸드북

데이터 제품 테스트 전략에 대해 다뤘습니다. 데이터 제품의 목표와 구성 요소, 라이프사이클 전반에 걸친 테스트 단계 등을 살펴보며, 이를 통해 데이터 품질 보장 및 비즈니스 성과 향상을 위한 명확한 전략을 제시합니다.

- 데이터 제품 테스트의 주요 목표 및 중요성을 설명함

- 데이터 제품의 라이프사이클에서 각 단계별 테스트 방법론 제시

- 비즈니스 논리 및 변환 검증을 위한 중요성을 강조

- AI와 자동화를 통한 미래 데이터 제품 테스트의 발전 방향 예측

현대 데이터 101에서 다루는 "데이터 제품 테스트 전략 핸드북"은 데이터 제품의 품질 보증을 보장하기 위한 전략과 실행 방법을 체계적으로 설명합니다. 이 핸드북은 데이터 제품 주기 전반에 걸친 테스트의 중요성과 각 단계에서의 테스트 방법을 제시합니다.

핸드북의 구성은 다음과 같습니다:

- 데이터 제품 개요: 데이터 제품이란 데이터, 메타데이터, 논리 및 템플릿의 통합된 조합을 의미합니다. 제품은 소비 가능하고 최신이며 승인을 받아야 하는 데이터 구성 요소로 이루어져 있습니다.

- 데이터 제품 테스트의 목표: 데이터 품질과 일관성 보장, 비즈니스 논리 및 변환 검증, 시스템 성능 모니터링, 보안 및 규정 준수 강화를 목표로 합니다. 각 목표를 달성함으로써 직관적이고 신뢰할 수 있는 데이터 제품을 제공합니다.

- 데이터 제품 테스트 전략 구성 요소: 명확한 테스트 범위 설정, 다층형 통합 테스트, 테스트 환경 사양, 테스트 접근성, 통합 릴리즈 관리, 실패 대응 계획, 그리고 테스트 검토 및 승인 프로세스가 포함됩니다.

- 각 데이터 제품의 테스트 고려 사항: 인프라 안정성, 코드의 정확성, 데이터 모델과 품질, 성능 검토 등 다양한 요소를 검토해야 합니다.

- 데이터 제품 주기 각 단계에서의 테스트 방법: 설계, 개발, 배포 및 발전 단계별로 각각의 테스트 요구 사항을 설명합니다. 특히 설계 단계에서는 서비스 수준 목표(SLOs)와 지표(SLIs)를 설정하여 제품 가치를 정의하며, 개발 단계에서는 데이터 수집 및 파이프라인 테스트를 수행합니다. 배포 단계에서는 사용자 경험을 고려한 기능 테스트와 API 테스트를 진행하고, 발전 단계에서는 데이터 품질 및 보안 테스트를 통해 지속적인 개선을 추구합니다.

- 데이터 제품 테스트 전략 촉진: 데이터 계약과 SLO/SLI의 역할, 자율 서비스 플랫폼의 중요성, 그리고 테스트 대시보드를 통해 사용자 채택 증진의 필요성을 강조합니다.

- 미래의 데이터 제품 테스트 경향: AI 및 자동화를 통한 자율적인 품질 보증, 자가 치유 파이프라인의 구현 및 데이터 관리와 테스트의 통합 등을 전망합니다.

이 핸드북은 데이터 제품의 품질을 극대화하고, 지속적인 혁신을 통해 고객에게 가치를 제공하는 방법에 대한 실제적인 접근 방식을 제공합니다. 조직에 적합한 데이터 테스트 전략을 수립하기 위한 포괄적이고 체계적인 가이드를 제공합니다.

Modern Data 101

The Data Product Testing Strategy: Handbook

⭐️ LLM을 활용하여 테스트 마이그레이션 가속화

Airbnb는 대규모의 LLM(대형 언어 모델) 기반 코드 마이그레이션을 통해 3,500개의 React 컴포넌트 테스트 파일을 Enzyme에서 React Testing Library로 신속하게 변환하였습니다. 이를 통해 엔지니어링 시간의 예상치인 1.5년을 6주 만에 달성하였으며, LLM을 활용한 자동화 도구의 구조와 마이그레이션 과정에서 직면한 도전들을 상세히 설명합니다.

- LLM을 활용하여 Enzyme에서 RTL로의 코드 변환을 자동화하였습니다.

- 파일 마이그레이션을 단계 구분하여 진행하고, 동적 프롬프트 실험을 통해 성공률을 높였습니다.

- 복잡한 파일의 경우 관련 정보와 예제를 포함한 풍부한 맥락을 제공하여 LLM의 이해도를 높였습니다.

- 이 과정을 통해 자동화로 75%의 파일을 완료하고, 4일의 피드백 루프를 통해 97%까지 완료하였습니다.

개요

Airbnb는 최근에 대규모 LLM(대형 언어 모델) 기반 코드 마이그레이션을 완료하였습니다. 이 프로젝트는 3,500여 개의 React 컴포넌트 테스트 파일을 Enzyme에서 React Testing Library(RTL)로 전환하는 작업이었습니다. 처음에는 손으로 진행할 경우 1년 반이 소요될 것으로 예상했으나, LLM과 자동화 도구를 결합하여 단 6주 만에 완료하였습니다. 이 글에서는 Enzyme에서 RTL로의 마이그레이션 과정에서 직면한 도전 과제, LLM을 활용한 해결 방법, 그리고 대규모 마이그레이션 도구를 구성하는 방법을 소개합니다.

배경

Airbnb는 2020년부터 새로 개발되는 React 컴포넌트 테스트에 RTL을 채택했으며, 이는 Enzyme에서 벗어나는 첫걸음이었습니다. Enzyme은 초기 React 버전을 위해 설계되었으며, 시간이 지나면서 현대 React 테스트 관행과 어긋나게 되었습니다. Enzyme 파일을 삭제하는 것은 코드 커버리지가 심각하게 저하될 수 있어, 자동화된 방법으로 테스트 파일을 리팩토링해야 했습니다.

어떻게 진행했나

2023년 중반, 해커톤 팀이 LLM을 활용해 Enzyme 파일을 RTL로 변환하는 실행 가능성을 보여주었습니다. 이를 바탕으로 2024년에는 LLM 기반 마이그레이션을 위한 확장 가능한 파이프라인을 개발했습니다. 주요 방법으로 각 파일을 단계적으로 처리하고, 중복으로 시도하고, 다양한 맥락을 포함한 프롬프트를 활용했습니다.

- 파일 검증 및 리팩터 단계: 파일을 여러 단계로 나누어 검증과 리팩토링을 진행했으며, 각 단계에서 실패할 경우 LLM을 활용해 수정했습니다.

- 재시도 루프 및 동적 프롬프트: 초기 단계에서 여러 프롬프트 전략을 시험해본 후, 재시도하는 방법이 가장 효과적임을 발견하였습니다. LLM에 오류를 주고 이전 파일 버전을 제공하는 방식으로 유동적인 프롬프트를 설정했습니다.

- 맥락 증대: 복잡한 테스트 파일에는 가능한 많은 관련 정보를 포함하여 LLM에 프롬프트를 전달했습니다. 각 프롬프트는 관련 파일, 수동으로 작성한 예시, 기존의 올바른 테스트 파일 등을 포함했습니다.

- 체계적인 개선: 75%의 성공률에 이른 후, 남은 파일에 대해 공통 문제를 파악하고 해결하기 위한 체계적인 접근을 도입했습니다. 상태를 자동으로 기록하는 시스템을 구축하고, 특정 단계에서 문제가 발생한 파일을 쉽게 재실행할 수 있도록 했습니다.

결과 및 영향

유효성 검사 및 리팩터 파이프라인, 재시도 루프, 그리고 확장된 맥락 덕분에 많은 파일을 빠르게 자동으로 마이그레이션할 수 있었습니다. 4일 동안의 개선 작업을 통해 3.5K개의 원본 Enzyme 파일 중 97%를 마이그레이션하였고, 남은 파일은 수동으로 완료했습니다. 이 과정을 통해 원래의 테스트 의도와 코드 커버리지를 유지하면서, 자동화의 전반적인 효율성이 대폭 개선되었습니다.

결론

이 마이그레이션 사례는 대규모 코드 변환을 위한 LLM의 능력을 보여주며, 앞으로 이 접근 방식을 확장하고 새로운 자동화 도구를 개발하여 개발자 생산성을 높일 계획입니다.

The Airbnb Tech Blog

Accelerating Large-Scale Test Migration with LLMs

⭐️ Late-Arriving Data 처리 전략 8가지

예상 도착 시간을 넘긴 데이터의 처리를 위한 전략을 다룹니다. 늦게 도착한 데이터는 분석과 보고에 악영향을 미칠 수 있으며, 이를 효과적으로 관리하는 방법에 대한 통찰을 제공합니다.

- 시스템 장애, 데이터 품질 문제 및 운영상의 도전이 지연의 주요 원인입니다.

- 늦게 도착한 데이터를 관리하기 위한 여러 전략이 제시됩니다.

- 이러한 전략을 통해 데이터의 유효성과 신뢰성을 유지할 수 있는 방법을 설명합니다.

이 글은 ‘늦게 도착하는 데이터(Late-Arriving Data)’를 처리하는 전략에 대해 다루고 있습니다. 데이터는 예상된 도착 시간에 맞춰 도착하지 않을 수 있으며, 이러한 상황은 분석, 보고서 작성 및 비즈니스 운영에 큰 영향을 미칠 수 있습니다. 저자는 이러한 데이터의 처리가 데이터의 정합성과 신뢰성을 유지하는 데 중요하다고 강조합니다.

늦게 도착하는 데이터의 정의

늦게 도착하는 데이터는 의도한 처리 시간을 넘어 지연되는 기록을 의미합니다. 이러한 지연은 다음과 같은 여러 원인으로 발생할 수 있습니다:

- 시스템 장애: 데이터 전송 또는 처리의 중단

- 데이터 품질 문제: 불완전하거나 부정확한 데이터로 인한 추가 검증 및 수정 시간

- 운영상의 문제: 수작업 데이터 입력 오류나 데이터 생성 지연

예를 들어, 전자상거래 플랫폼에서 실시간으로 판매 거래를 처리할 때, 네트워크 문제로 거래 기록이 늦게 도착하면 판매 보고서와 재고 관리에 불일치가 발생할 수 있습니다.

늦게 도착하는 데이터 처리 전략

늦게 도착하는 데이터를 효과적으로 관리하기 위한 여러 가지 전략이 있습니다. 다음은 몇 가지 접근 방식의 예시입니다:

| 인덱스 | 전략 | 설명 | 장점 | 단점 |

|---|---|---|---|---|

| 1 | 데이터 업데이트 (덮어쓰기) | 도착한 최신 데이터로 기존 데이터를 덮어씀. | 가장 최신 데이터를 유지. | 과거 데이터 손실 위험. |

| 2 | 이중 시간 모델링 | 데이터가 기록된 시간과 의도된 시간을 따로 관리. | 실제 기록 시간과 의도된 시간을 모두 제공. | 모델링 및 쿼리 복잡도 증가. |

| 3 | 지연 데이터 무시 | 지연 데이터를 무시하고 정해진 일정대로 처리. | 단순하며 재처리 부담이 없음. | 유용한 정보 손실 가능성. |

| 4 | 우선 처리, 이후 보완 | 가용한 데이터를 우선 처리하고, 지연 데이터 도착 시 업데이트. | 빠른 응답 시스템에 적합. | 업데이트 및 조정 메커니즘 필요. |

| 5 | 지연 차원 데이터 조기 감지 | 초기 데이터 처리 단계에서 지연 데이터를 식별. | 데이터 품질 관리 향상. | 추가적인 처리 논리 필요. |

| 6 | 조정 패턴 | 지연 데이터를 기존 기록과 조정하여 일관성을 유지. | 데이터 정확성과 일관성 유지. | 리소스 집약적이며 강력한 추적 시스템 필요. |

| 7 | 차원 없이 사실 데이터 처리 금지 | 차원 데이터가 없으면 사실 데이터를 처리하지 않음. | 참조 무결성을 유지. | 사실 데이터 처리가 지연될 수 있음. |

| 8 | 임시 저장 후 재시도 | 지연 데이터를 임시 저장소에 보관하고 나중에 처리. | 지연된 데이터를 나중에 처리 가능. | 추가 저장 공간 및 모니터링 필요. |

이러한 전략들은 데이터의 지연으로 인한 부정적인 영향을 최소화하고 데이터 품질을 유지하는 데 도움을 줄 수 있습니다. 저자는 이러한 지연된 데이터 문제를 해결하기 위해 기업들이 사용할 수 있는 다양한 방법들을 제시하며, 데이터 엔지니어링 분야의 중요성과 그에 대한 깊이 있는 이해를 강조합니다.

Data Engineer Things

8 Late-Arriving Data Handling Strategies

⭐️ 데이터 엔지니어링 기술을 향상시키기 위한 10가지 필수 데이터 집계 기법

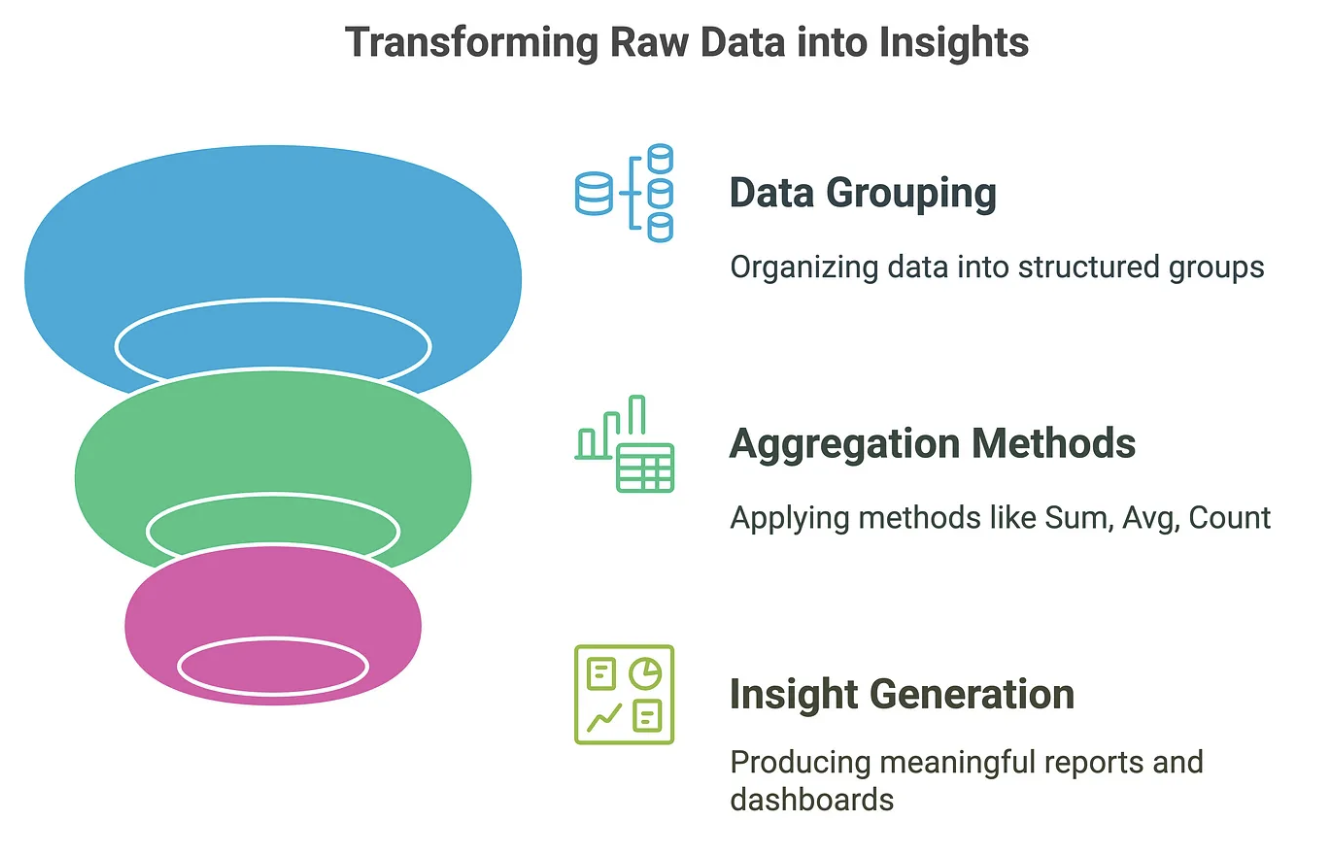

이 글은 데이터 엔지니어링 분야에서 필수적인 데이터 집계 기술들을 설명하며, 이를 통해 데이터 처리 효율성을 개선할 수 있는 방법들을 소개합니다. 데이터 집계의 중요성과 여러 가지 기법을 소개하여, 데이터 엔지니어들이 업무를 최적화하는 데 도움을 주고자 합니다.

- 데이터 집계의 정의와 필요성 설명

- 10가지 주요 데이터 집계 기법 소개 (예: 사전 집계, 증분 집계, 근사 집계 등)

- 효과적인 데이터 집계를 위한 모범 사례 제시

개요

데이터 집계(data aggregation)는 원시 데이터를 수집하고 요약하여 분석, 보고 및 의사결정을 위한 유용한 형태로 만드는 과정입니다. 데이터 엔지니어는 대량의 데이터를 다루면서 효과적인 집계 기술이 없다면 의미 있는 통찰력을 얻기 어렵습니다. 본 글에서는 산업에서 사용되는 가장 효과적인 데이터 집계 기술 10가지를 살펴보고, 이를 통해 데이터 처리의 효율성을 어떻게 향상시킬 수 있는지 설명합니다.

데이터 집계의 중요성

데이터 집계는 기업이 원시 데이터의 홍수 속에서 유용한 정보를 찾도록 도와줍니다. 집계를 통해 쿼리 성능을 개선하고, 의사결정을 강화하며, 저장 비용을 최적화할 수 있습니다. 예를 들어, 대신에 수천 건의 개별 데이터를 분석하는 대신, 기업은 월간 총 판매량이나 지역별 활성 사용자 수와 같은 집계된 지표를 사용할 수 있습니다.

산업에서 사용되는 10가지 데이터 집계 기술

| 구분 | 특징 | 예시 |

| Pre-Aggregation | 사전 집계로 쿼리 부하 감소 | 일일 매출 합계 미리 계산 |

| Incremental Aggregation | 변경된 데이터만 처리하여 속도 향상 | 당일 매출만 추가하여 총합 업데이트 |

| Approximate Aggregations | 속도 우선, 근사치 계산 | HyperLogLog으로 방문자 수 추정 |

| Window Functions | 시간 기반 연속 데이터 집계 | 7일 이동 평균 계산 |

| Aggregation with Partitioning | 데이터 분할로 빠른 검색 가능 | 지역별 판매 집계 |

| Materialized Views | 미리 계산된 결과 저장으로 쿼리 최적화 | 월별 매출 합계 저장 |

| Hierarchical Aggregation | 다단계 집계로 드릴다운 분석 지원 | 국가 → 지역 → 도시별 판매 보고 |

| Streaming Aggregation | 실시간 데이터 스트리밍 집계 처리 | 실시간 사용자 활동 추적 |

| Percentile-Based Aggregation | 평균보다 세밀한 지표 제공 | P95, P99 응답 시간 추적 |

| Composite Aggregation | 여러 기법 결합으로 최적 성능 달성 | 일일 집계와 실시간 근사치 집계 결합 |

효과적인 데이터 집계를 위한 모범 사례

- 적절한 집계 수준 선택

- 인덱싱 및 파티셔닝 활용

- 물리화 뷰 활용

- 실시간 요구에 최적화

- 성능 테스트 실시

- 과도한 집계 피하기

- 쿼리 모니터링 및 조정

결론

데이터 집계 기법은 데이터 엔지니어에게 있어 필수적인 스킬입니다. 실시간 분석, 배치 처리 또는 대규모 보고를 처리할 때, 적절한 집계 기법을 사용하는 것은 성능을 극대화하고 비용 효율성을 개선하는 데 크게 기여합니다. 데이터 집계의 중요성과 다양한 기술을 이해하고 적용함으로써 데이터 엔지니어로서의 역량을 강화할 수 있습니다.

Data Engineer Things

10 Must-Know Data Aggregation Techniques to Supercharge Your Data Engineering Skills

⭐️ 스파크 최적화하기

PySpark의 성능 최적화에 주목하여, LIKE 조인 대신 정규 표현식을 활용한 방법을 통해 데이터 처리 속도를 두 배로 향상시키는 실질적인 예제를 다룹니다. 이러한 기술을 통해 클라우드 비용 절감과 데이터 분석 효율성을 극대화할 수 있습니다.

- PySpark 성능 최적화를 위해 LIKE 조인 대신 정규 표현식 사용

- 대량의 데이터 처리 시 비용 절감 및 처리 시간 단축

- 정규 표현식 활용 방법 및 효과적인 데이터 조인 수행 기술 소개

이 글은 데이터 엔지니어링에서 효율적인 PySpark 코드 최적화 방법에 대한 실용적인 예제를 다루고 있습니다. 저자는 Spark 최적화 시리즈의 두 번째 부분으로, 대규모 테이블 처리에 있어 최적화된 코드를 작성하는 것이 클라우드 비용 절감 및 처리 시간을 단축시키는 데 얼마나 중요한지를 설명합니다.

주요 내용은 다음과 같습니다:

- 문제 소개

- 대규모 거래 데이터를 저장하는 테이블(Transactions)과 이를 분류하기 위한 카테고리 테이블(Categorization)을 소개합니다. 이 두 테이블은 조건문 LIKE를 이용하여 조인됩니다.

- 핵심

- Spark는 rlike(정규식) 연산자를 사용하면 JVM의 정규식 엔진을 활용합니다. 이 엔진은 정규식을 효율적으로 컴파일하고 내부적으로 최적화된 방식으로 패턴 매칭을 수행합니다. 정규식이 한 번 컴파일되면 같은 패턴을 여러 번 사용할 경우 매우 빠르게 작동할 수 있습니다.

- LIKE 연산자는 단순한 패턴 매칭(예: '%abc%')을 수행하지만, 이는 내부적으로 문자열을 하나씩 비교하는 방식으로 구현될 수 있습니다. LIKE는 정규식보다 덜 최적화되어 있고, 특히 와일드카드(% 또는 _ 등)가 포함될 경우 전체 문자열을 스캔해야 하는 경우가 많습니다.

- 더미 데이터 생성

- 예제로 사용되는 두 테이블의 구조와 데이터를 생성하는 과정이 상세하게 설명됩니다. 이 과정에서 거래 테이블의 커멘트를 무작위로 생성하고, 카테고리 테이블에 정의된 키워드와 조인하기 위한 준비를 합니다.

- 기존 솔루션과 최적화 솔루션

- 기존의 LIKE 조인 방식은 성능이 떨어지며, 이를 개선하기 위해 정규 표현식(Regex)을 사용하는 방식으로 변경합니다. 저자는 RegexMatcher와 Spark NLP 라이브러리를 활용하여 더 효율적으로 조인하는 방법을 제시합니다.

- 성능 비교

- 최적화된 솔루션이 원래의 솔루션보다 2배 더 빠르다는 결과를 제공합니다. 다만 카테고리 테이블의 행 수가 증가할 경우 성능 저하가 발생할 수 있는 점을 언급하며, 데이터에 맞춘 해결책을 설계하는 것이 중요하다고 강조합니다.

- 결론

- 데이터 엔지니어링에서 코드를 최적화하는 것이 얼마나 중요한지를 다시 한번 강조하며, 새로운 처리 기술을 이용한 성능 개선이 가능하다는 점에서, 프로그래밍 언어의 추상화에 얽매이지 않고 창의적인 접근이 필요하다고 주장합니다.

해결책 요약 표:

| 문제 | 기존 솔루션 (LIKE 조인) | 최적화 솔루션 (Regex 사용) |

|---|---|---|

| 처리 시간 | 느림 (비효율적) | 2배 빠름 |

| 코드 복잡도 | 단순하지만 비효율적 | 상대적으로 복잡하지만 성능 향상 |

| 유지보수 용이성 | 복잡한 쿼리 작성 필요 | 모듈화된 라이브러리 사용으로 용이 |

이 글은 대규모 데이터 처리 시 성능 최적화를 위해 필요한 지식과 기술을 공유하고 있으며, 데이터 엔지니어링을 수행하는 데 있어 실질적인 가이드를 제공합니다.

Data Engineer Things

Optimizing Spark

⭐️ PySpark 성능 최적화: 주요 모범 사례

이 글은 PySpark의 성능 최적화를 위한 주요 방법론을 다룹니다. 블로그에서는 스키마 관리, 효율적인 조인 및 집계 방법, 적응형 쿼리 실행(AQE), 파티셔닝 및 버켓팅, 데이터 쓰기 최적화와 같은 기술들을 설명하고 있습니다.

- 스키마 정의의 중요성

- 브로드캐스트 조인 및 솔팅을 통한 병목 현상 방지

- Spark가 쿼리를 동적으로 최적화할 수 있도록 하는 AQE 활용

- 쿼리 성능 향상을 위한 파티셔닝 및 버켓팅 최적화

- 효율성을 위한 Parquet 및 Delta 포맷 선택

개요

이 글은 PySpark의 성능 저하 문제와 최적화 방법을 다룹니다. 많은 데이터 엔지니어들이 실시간 분석을 위한 PySpark 파이프라인을 구축할 때 느린 쿼리, 조인 성능 저하, 데이터 스큐(Data Skew) 등 다양한 문제를 겪습니다. PySpark는 기본적으로 최적화되지 않았기 때문에 성능을 극대화하려면 적절한 튜닝과 최적화 전략이 필요합니다.

이 글에서는 PySpark의 주요 성능 저하 원인을 분석하고, 데이터 로딩, 변환, 조인 최적화, 쓰기 성능 개선 등 다양한 관점에서 실무에서 적용할 수 있는 최적화 기법을 소개합니다.

PySpark 파이프라인의 성능 저하 원인

PySpark가 느려지는 주요 원인은 다음과 같습니다.

| 성능 문제 | 원인 | 영향 |

|---|---|---|

| 느린 조인 및 집계 | 조인 시 과도한 셔플(Shuffling) 발생 | 실행 시간 증가 |

| 스키마 자동 추론(inferSchema) 사용 | Spark가 데이터를 스캔하여 스키마를 추론하는 과정에서 불필요한 연산 발생 | 로딩 속도 저하 |

| 데이터 스큐(Data Skew) | 특정 키에 데이터가 집중되어 특정 작업이 과부하 발생 | 작업 속도 불균형 |

| 비효율적인 데이터 변환 | 불필요한 컬럼 포함, 여러 번의 withColumn 사용 | 데이터 처리 속도 저하 |

| 비효율적인 데이터 저장 방식 | CSV 같은 비효율적인 형식 사용 | 저장 공간 낭비 및 읽기 속도 저하 |

이제 이러한 문제를 해결하는 실용적인 방법들을 살펴보겠습니다.

데이터 로딩 최적화

스키마 자동 추론을 피하고 명시적으로 정의하기

PySpark에서 inferSchema=True를 사용하면 데이터 로딩 시 추가적인 스캔이 발생해 성능이 저하됩니다.

대신 스키마를 명시적으로 정의하면 성능을 향상시킬 수 있습니다.

from pyspark.sql.types import StructType, StructField, IntegerType, StringType

schema = StructType([

StructField("id", IntegerType(), True),

StructField("name", StringType(), True),

StructField("salary", IntegerType(), True)

])

df = spark.read.schema(schema).json("data.json")

적용 효과: 스키마 추론 과정을 생략하여 데이터 로딩 속도를 단축하고, 데이터 타입 일관성을 유지할 수 있습니다.

데이터 변환 최적화

불필요한 컬럼 제거하기

컬럼을 선택적으로 로드하면 데이터 스캔량이 줄어들어 성능이 향상됩니다.

df = df.select("important_col1", "important_col2")

적용 효과: 필요 없는 컬럼을 미리 제거하여 데이터 크기를 줄이고 연산 속도를 높일 수 있습니다.

withColumn() 대신 select() 사용

여러 개의 컬럼을 추가할 때 withColumn()을 여러 번 사용하면 매번 새로운 DataFrame이 생성되어 성능이 저하됩니다.

대신 select()를 사용하면 더 효율적입니다.

from pyspark.sql.functions import lit

df = df.select("*", lit("new_value").alias("new_column"))

적용 효과: 불필요한 실행 계획 생성을 방지하고 성능을 개선할 수 있습니다.

조인 및 집계 최적화

데이터 스큐 해결하기

데이터 스큐는 특정 키가 너무 많은 데이터를 가지는 문제입니다.

예를 들어, 한 지역의 트랜잭션이 전체의 90%를 차지하면, 해당 파티션이 과부하됩니다.

잘못된 해결 방법: Salting을 무조건 적용하기

from pyspark.sql.functions import col, lit, rand

df = df.withColumn("skew_key", col("key").cast("string") + lit("_") + (rand() * 10).cast("int"))

Salting은 조인 성능을 향상시킬 수 있지만, 조인 대상 테이블도 같은 방식으로 변환해야 합니다. 그렇지 않으면 올바른 매칭이 되지 않습니다.

더 나은 해결 방법

| 최적화 방법 | 설명 | 코드 예시 |

|---|---|---|

| 파티셔닝 개선 | repartition()으로 균등한 데이터 분배 |

df = df.repartition(10, "key") |

| AQE 활용 | Adaptive Query Execution(AQE) 활성화 | spark.conf.set("spark.sql.adaptive.enabled", True) |

| Skew Join 최적화 | Spark의 스큐 조인 최적화 기능 사용 | spark.conf.set("spark.sql.adaptive.skewJoin.enabled", True) |

| Broadcast Join 사용 | 작은 테이블을 브로드캐스트하여 조인 성능 향상 | df_joined = df.join(broadcast(small_df), "key") |

실행 계획 최적화

Spark의 기본 실행 계획은 정적으로 설정되지만, Adaptive Query Execution(AQE)를 사용하면 런타임에 최적화됩니다.

spark.conf.set("spark.sql.adaptive.enabled", True)

적용 효과: 조인 및 셔플 파티션 수를 자동 조정하여 최적의 실행 계획을 생성합니다.

데이터 저장 최적화

CSV와 같은 텍스트 기반 포맷은 비효율적이므로, Parquet 또는 Delta Lake를 사용하는 것이 좋습니다.

df.write.mode("overwrite").parquet("output.parquet")

df.write.format("delta").mode("append").save("delta_table_path")

적용 효과: 압축률이 높고 쿼리 성능이 개선됩니다.

결론

PySpark의 성능 최적화를 위해 고려해야 할 핵심 사항은 다음과 같습니다.

✅ 스키마를 명시적으로 정의하여 로딩 속도를 최적화하세요.

✅ AQE를 활성화하여 런타임에서 동적으로 최적화하세요.

✅ 데이터 스큐를 해결하기 위해 적절한 파티셔닝과 Skew Join 최적화를 사용하세요.

✅ 불필요한 컬럼을 제거하고, 비효율적인 변환을 피하세요.

✅ 조인 시 Broadcast를 활용하여 불필요한 셔플을 방지하세요.

✅ Parquet 또는 Delta Lake와 같은 최적화된 저장 포맷을 사용하세요.

이제 PySpark 최적화를 실무에 적용해 보세요! 여러분의 경험이나 질문을 댓글로 공유해주세요. 🚀

Top posts on r/dataengineering

Optimizing PySpark Performance: Key Best Practices

에어플로우를 넘어서: 데이터 오케스트레이션을 위한 6가지 훌륭한 대안

이 글에서는 현대 데이터 엔지니어링에서 데이터 오케스트레이션의 중요성을 강조하며, Apache Airflow 외에도 프로젝트의 특정 요구에 맞는 여섯 가지 대체 도구를 소개합니다. 각 도구의 고유한 기능과 장점을 분석하여 사용자들이 올바른 오케스트레이션 도구를 선택할 수 있도록 돕고 있습니다.

- 피플톤: Flyte, Prefect, Dagster, Mage AI, Kedro, Luigi 등 6가지 도구 소개

- 각 도구의 기능 및 적합한 사용 사례 강조

- 데이터 공학과 머신러닝 작업을 최적화하는 데 중요한 역할 수행

개요

현대 데이터 엔지니어링에서 데이터 오케스트레이션은 팀이 데이터 작업 흐름을 자동화하고 최적화하는 데 중요한 역할을 합니다. Apache Airflow는 그 유연성과 활발한 커뮤니티 덕분에 오랜 기간 동안 인기를 끌어왔지만, 특정 프로젝트 요구에 더 잘 맞는 여러 대안들도 존재합니다. 이 글에서는 Apache Airflow에 대한 6가지 매력적인 대안을 탐구하며, 각 도구가 제공하는 독특한 기능이 어떻게 데이터 엔지니어링 및 머신러닝 작업 흐름을 지원하는지를 설명합니다.

| 도구 | 주요 기능 | 설명 |

|---|---|---|

| Flyte | 클라우드 네이티브 | Kubernetes 우선 설계, 대규모 작업에 최적화 |

| 데이터 라인인지 | 작업 흐름의 버전 관리 및 모니터링 기능 제공 | |

| Prefect | 하이브리드 실행 모델 | 클라우드와 온프레미스에서 유연하게 사용 가능 |

| 실시간 모니터링 | 사용자 인터페이스를 통한 직관적인 관찰 가능 | |

| Dagster | 통합 데이터 라인인지 | 고급 관찰 가능성을 위한 설계 |

| 클라우드 네이티브 | 확장성과 유연성을 제공하는 아키텍처 | |

| Mage AI | 실시간 모니터링 | 경고 및 시각화 도구를 통한 관리 |

| dbt 통합 | 데이터 모델 관리를 간편하게 지원 | |

| Kedro | 일관된 프로젝트 구조 | 표준화된 템플릿 및 코딩 규약 제공 |

| 유연한 배포 | 다양한 플랫폼에서의 유연한 배포 가능 | |

| Luigi | 의존성 해결 | 작업 실행 순서 보장을 위한 기능 |

| 시각화 도구 | 작업의 상태를 시각적으로 확인 가능 |

결론

Apache Airflow가 여전히 널리 사용되는 도구이지만, 소개된 6가지 대안은 각각의 고유한 장점을 가지고 있어 특정 사용 사례에 더 적합할 수 있습니다. 팀의 요구에 맞는 도구를 선택함으로써 데이터 작업 흐름을 최적화하고 데이터 엔지니어링 및 머신러닝 작업의 효율성을 향상시킬 수 있습니다.

Data Engineer Things

Beyond Airflow: 6 Great Alternatives for Data Orchestration

주의: Redshift Serverless와 Zero-ETL

이 글에서는 Redshift Serverless와 Zero-ETL 통합 사용에 따른 문제점을 경고하고 있습니다. 특히, 비용 문제와 자동 일시 중지 기능이 제대로 작동하지 않는 현상으로 인해 많은 사용자가 예상 외의 비용을 발생시키는 경험을 공유하고 있습니다.

- Redshift Serverless는 기본적으로 128 RPUs로 설정되며 매우 비쌉니다. (RPU: Redshift Processing Units)

- Zero-ETL 통합으로 인해 항상 쿼리 대기열이 활성화되어 자동 일시 중지가 거의 작동하지 않음. (Zero ETL 관련 문서)

- 적은 비용을 원한다면 작은 Redshift 온디맨드 인스턴스 사용이 더 바람직함.

- Redshift Serverless와 Zero-ETL 사용을 피하는 것이 좋음.

개요

이 글은 Redshift Serverless와 Zero-ETL 통합을 사용할 때 겪었던 문제를 공유한 후, 해당 조합이 비효율적이라는 경고를 전달합니다. 작성자는 AWS RDS 데이터베이스가 성장하면서 Metabase 대시보드가 타임아웃 되는 경험을 하였고, Snowflake, DataBricks, Redshift 등 여러 대안을 고려한 끝에 AWS 생태계를 유지하기로 결정하게 됩니다. 리더들은 Redshift의 Serverless 옵션과 Zero-ETL 통합을 사용하려 했지만, 비용이 예상보다 훨씬 증가한 문제를 겪게 됩니다.

문제의 세부 사항

- Redshift Serverless는 기본적으로 128 RPUs(Resource Processing Units)를 사용하며, 이는 매우 높은 비용을 초래합니다.

- Zero-ETL 통합은 RDS에서 Redshift로의 데이터 이동을 지속적으로 발생시켜 약정 중인 자동 일시 중지 기능을 거의 항상 활성 상태로 유지합니다. 이는 예상 하루 비용을 1,000달러에서 시작하도록 유도합니다.

- 최종적으로 작성자는 Redshift의 온프레미스 인스턴스를 선택하고, 월 약 400달러의 비용으로 안정적인 성능을 얻었다고 보고합니다.

대안 및 조언

저자는 Redshift Serverless와 Zero-ETL 통합을 사용하지 말 것을 추천하며, 필요하다면 Glue나 DMS를 사용해 데이터를 주기적으로 이동시키는 방법을 고려해야 한다고 조언합니다. 또한, Redshift의 다른 인스턴스를 사용하는 것이 더 경제적일 수 있다고 강조합니다.

결론

결국, Redshift Serverless와 Zero-ETL의 조합은 많은 경우에 비효율적일 수 있으며 관리자들은 비용 문제와 데이터 패턴을 정확히 이해하고 적절한 선택을 해야 할 필요가 있습니다. 이와 관련하여 대안적인 옵션과 비용 절감 방법을 찾는 것이 중요합니다.

Top posts on r/dataengineering

BEWARE Redshift Serverless + Zero-ETL

현재 데이터 스택이 너무 복잡함: 70%의 데이터 리더와 실무자들이 동의

현재 데이터 스택의 복잡함에 대해 70%의 데이터 리더와 실무자들이 동의하고 있습니다. 이 복잡성은 다양한 도구와 플랫폼에 대한 의존성에서 기인하며, 데이터 엔지니어링의 효율성을 저해하는 주요 요인으로 작용하고 있습니다.

- 데이터 스택의 복잡성이 해결되지 않으면 비즈니스 운영에 부정적 영향을 미칠 수 있음.

- 기술의 추가가 아니라, 올바른 전략과 운영에서 문제를 해결해야 함.

- 통합된 데이터 솔루션의 필요성이 더욱 강조되고 있음.

현재 데이터 스택의 복잡성에 대한 연구에 따르면, 70%의 데이터 리더와 실무자들이 현재의 데이터 구조가 너무 복잡하다고 느끼고 있습니다. 이 글에서는 이러한 복잡성을 야기하는 여러 요소와 대안적인 해결책을 모색하고 있습니다.

주요 내용은 다음과 같습니다:

- 데이터 스택의 복잡성 원인: 데이터 스택이 복잡해지는 원인으로는 다양한 데이터 처리 도구와 기법의 필요성이 있습니다. 예를 들어, 데이터 추출(ETL), 데이터 변환, 데이터 로딩 및 데이터 거버넌스와 같은 다양한 분야에서의 복잡한 요구사항이 포함되어 있습니다. 이러한 요구사항은 데이터 엔지니어들이 다양한 툴과 플랫폼을 사용할 수밖에 없도록 강요합니다.

- 복잡성과 복잡함의 차이: 글에서는 '복잡성(complexity)'과 '복잡함(complicatedness)'의 개념을 구분하고 있습니다. 복잡성은 본질적으로 데이터의 특성에서 비롯되지만, 절차나 시스템의 복잡함은 불필요한 요소로 인해 발생합니다. 따라서 복잡성을 효율적으로 관리하는 기술이 필요하다는 점이 강조됩니다.

- 기술적 해결책: 현재 제안된 기술적 해결책들은 주로 데이터 스트림의 통합과 효율적인 데이터 처리 방법에 중점을 두고 있습니다. 예를 들어, 데이터 파이프라인을 단순화하고, 중복되는 프로세스를 없애는 방식으로 증가하는 요구사항에 대처할 수 있는 방법을 모색합니다.

- 전략적 접근 필요성: 데이터 엔지니어링의 복잡성을 해결하기 위해서는 기술적인 해결책뿐만 아니라 운영 및 전략적인 접근이 중요하다는 점이 강조됩니다. 데이터 사용자의 요구사항을 충족시키기 위한 체계적인 계획과 실행이 필요하다는 것입니다.

- 실제 사례 및 견해 공유: 여러 댓글을 통해 다양한 데이터 전문가들이 자신의 경험과 의견을 공유하며, 데이터 엔지니어링 환경에서의 문제와 해결 방안에 대해서도 논의하고 있습니다. 이를 통해 데이터 스택의 복잡성을 줄이기 위한 다양한 시각과 접근 방법을 볼 수 있습니다.

아래의 표는 복잡한 데이터 스택과 관련된 주요 개념을 요약한 것입니다.

| 요인 | 설명 |

|---|---|

| 데이터 추출(ETL) | 데이터 소스에서 필요한 데이터를 추출하는 과정 |

| 데이터 변환 | 데이터를 분석 및 활용하기 쉬운 형태로 변경하는 과정 |

| 데이터 로딩 | 변환된 데이터를 저장소에 기록하는 과정 |

| 거버넌스 | 데이터 품질과 보안을 관리하기 위한 규제 및 정책 |

| 복잡성과 복잡함의 차이 | 본질적 복잡성과 불필요한 복잡함을 구분하는 중요성 |

| 기술적 접근 | 새로운 기술과 도구를 효과적으로 통합하는 방법 |

| 전략적 접근 | 데이터 사용자의 요구를 충족시키기 위한 포괄적인 계획과 실행 |

이 글은 데이터 엔지니어링에서의 복잡성을 이해하고 이를 해결하기 위한 전략적인 노력을 강조하며, 여러 전문가들의 실질적인 경험을 공유함으로써 독자들에게 실용적인 인사이트를 제공합니다.

Top posts on r/dataengineering

The Current Data Stack is Too Complex: 70% Data Leaders & Practitioners Agree

DuckDB 로컬 UI 출시

DuckDB가 사용자 친화적인 로컬 UI를 출시했습니다. 이 UI는 더 나은 데이터 분석 경험을 제공하여 사용자의 데이터 작업을 더욱 간편하게 만들어 줄 것으로 기대됩니다.

- DuckDB의 로컬 UI는 직관적인 쿼리 작성 환경을 제공합니다.

- 사용자는 UI를 통해 데이터 분석 작업을 기존보다 더 효과적으로 수행할 수 있습니다.

- 새로운 UI는 커뮤니티의 긍정적인 반응을 이끌어내고 있으며, 오픈 소스화 가능성도 논의되고 있습니다.

DuckDB가 새로운 로컬 UI를 출시했다는 내용을 다룬 Reddit의 데이터 엔지니어링 커뮤니티 게시글입니다. 이 게시글은 DuckDB의 로컬 UI에 대한 사용자의 반응과 의견을 공유하는 플랫폼으로, 다양한 의견과 질문들이 댓글로 이어지고 있습니다.

주요 내용은 다음과 같습니다:

- DuckDB 로컬 UI 출시: DuckDB는 데이터베이스 관리 시스템으로 널리 알려져 있으며, 이번에 사용자 친화적인 인터페이스를 추가해 사용자 경험을 개선하고자 했습니다.

- 사용자 피드백: 사용자는 새로운 UI에 대한 다양한 반응을 보이고 있으며, "멋지다", "와우" 같은 긍정적인 반응에서부터 "이 UI가 정말 필요했는가?" 같은 회의적인 질문까지 다양합니다. 예를 들어, 한 사용자는 기존의 DB 관리 도구인 DBeaver를 대체할 수 있을지에 대한 의문을 제기했습니다.

- 코드 접근성: UI의 클라이언트 코드나 오픈소스 여부에 대한 질문이 있었으며, 이에 대한 답변으로 해당 UI가 Motherduck UI의 포크일 가능성이 언급되었습니다. 또한 GitHub 링크를 통해 일부 코드에 접근할 수 있다는 정보도 제공되었습니다.

- 기타 유사 도구와 비교: 일부 사용자는 Azure Data Studio와 같은 기존 도구들과의 차이점에 대한 질문을 하였으며, DuckDB의 인기에 대한 배경을 설명하고 있습니다.

- 커뮤니티 활성화: DuckDB UI에 대한 흥미로운 토론이 활발하게 이루어져 있으며, 사용자들은 자발적으로 그들의 경험과 기대를 공유하고 있습니다. 이러한 소통은 커뮤니티에 긍정적인 영향을 미치고 있습니다.

이 자료는 데이터 엔지니어링과 관련된 커뮤니티의 반응을 잘 보여주며, DuckDB의 최신 기능에 대한 사용자 의견을 이해하는 데 도움이 될 것입니다.

Top posts on r/dataengineering

DuckDB released a local UI

최고 기업의 데이터 엔지니어링 질문 600개 이상 분석하기

600개 이상의 데이터 엔지니어링 질문을 수집해 무료로 제공하는 리소스를 소개합니다. 데이터 엔지니어링 분야의 면접 준비에 유용할 질문들이 카테고리별로 정리되어 있으며, 앞으로 추가 질문도 업데이트될 예정입니다.

- 600개 이상의 데이터 엔지니어링 면접 질문을 무료로 제공

- Spark, SQL, 클라우드 관련 질문 500개 추가 예정

- 하루 5개, 월 100개까지 질문 접근 가능

이 글은 데이터 엔지니어링 관련된 질문들을 수집하고 정리한 내용으로, 전체 600개 이상의 질문이 포함되어 있습니다. 수집 과정은 약 5개월이 걸렸으며, 이 질문들은 주요 기업들의 인터뷰 과정에서 사용되는 질문들입니다. 이 자료는 데이터 엔지니어링 관련 인터뷰 준비에 도움을 주기 위해 만들어졌습니다.

기본적으로 제공되는 질문은 다음과 같은 주제를 포괄합니다:

| 주제 | 설명 |

|---|---|

| 데이터 파이프라인 | 데이터의 흐름을 관리하기 위한 설계 및 구현 이슈 |

| 데이터베이스 | 데이터 저장소의 구조 및 관리 방법 |

| 데이터 형식 | 다양한 데이터 형식의 정의와 활용 방법 |

| 데이터 모델링 | 데이터 베이스 설계 및 데이터 구조 정의 |

| 데이터 거버넌스 | 데이터 관리를 위한 정책 및 프로세스 |

| 데이터 정제 | 데이터에서 오류나 중복을 제거하는 방법 |

| NoSQL | 비관계형 데이터베이스 관련 질문 |

| 분산 시스템 | 데이터 처리와 저장을 위한 시스템 설계 |

| 스트리밍 | 실시간 데이터 처리 방법 |

| 배치 | 대량의 데이터를 처리하는 방식 |

| 빅데이터 | 대규모 데이터 처리와 관련된 기술 |

| 워크플로우 엔진 | 데이터 처리 과정의 자동화 및 관리 |

현재 사용자는 하루에 최대 5개의 질문, 또는 한 달에 100개의 질문을 무료로 이용할 수 있습니다. 질문들은 Spark, SQL, 클라우드 관련 질문들을 추가할 계획도 존재합니다. 이용자는 제공된 링크를 통해 더 많은 질문을 확인할 수 있으며, 질문 수집 및 가공 방법에 대한 정보도 원문에서 확인할 수 있습니다.

이 자료는 데이터 엔지니어링 분야에 관심이 있는 사람들에게 유용할 것으로 기대됩니다. 인터뷰 준비에 대한 필요를 느끼는 분들께는 상당한 도움이 될 것입니다.

Top posts on r/dataengineering

Parsed 600+ Data Engineering Questions from top Companies

DBT에 대한 생각은?

이 글에서는 DBT(Data Build Tool)에 대한 사용자의 경험과 그에 대한 의견을 나누는 토론을 다루고 있습니다. 작성자는 DBT가 비효율적이라고 느꼈고, Snowflake 작업을 활용했을 때의 대안적인 접근 방식에 대해 논의하고 있으며, 다른 사용자들은 DBT의 장단점에 대한 피드백과 경험을 공유하고 있습니다.

- DBT 사용에 대한 개인적인 의견을 게시한 사용자와 관련된 다양한 반응

- DBT의 유용한 기능과 그에 대한 비판적 시각

- Snowflake 등 다른 도구와의 비교 및 다양한 상황에서의 DBT 활용 사례

- DBT의 장점으로 모델 계보 보장 및 코드 버전 관리 강조

개요

이 글에서는 데이터 엔지니어링 도구인 DBT(Data Build Tool)에 대한 사용자 의견과 경험을 공유한 Reddit 커뮤니티의 토론을 다룹니다. DBT 및 Snowflake를 사용하고 있는 한 IT 컨설팅 회사의 직원이 DBT의 복잡성과 필요성에 대해 질문을 남긴 것으로 시작됩니다. 사용자는 DBT가 작은 규모의 기업에 적합하다고 생각하지만, 더 큰 규모에서는 확장성이 부족하다고 느끼고 있습니다. 이후 커뮤니티 회원들은 DBT의 장점과 단점, 대안 도구들, 그리고 실제 사용 사례에 대해 논의합니다.

DBT의 장점

- 모델 라인이지 보장: DBT는 데이터 모델 간 의존 관계를 관리하여 사용자가 잘못된 실행 순서로 모델을 실행하는 것을 방지합니다.

- 코드 관리: SQL 코드와 테스트의 차이를 쉽게 확인할 수 있어 코드 관리가 용이합니다.

- 재사용성: 비즈니스 로직을 SQL로 재사용할 수 있도록 유도하여 유지보수성을 향상시킵니다.

DBT의 단점

- 복잡성: YAML 파일 관리가 복잡하고, 대규모 프로젝트에서는 처리 시간이 길어지는 문제가 발생할 수 있습니다.

- 한계점: DBT Core는 다중 프로젝트 지원 및 컬럼 단위의 라인이지 부족 등 여러 네이티브 기능이 부족합니다. DBT Cloud는 이러한 문제를 일부 해결하지만 추가 비용이 발생합니다.

대안 도구

- SQLMesh: 사용자가 언급한 대안 도구로, DBT의 복잡성을 줄이고 더 나은 환경 관리를 제공합니다. 특히, 모델의 특정 변경 시 해당 의존성만 새로 고칠 수 있는 기능이 유용하다고 여겨집니다.

결론

DBT는 많은 데이터 엔지니어들에게 유용한 도구이지만, 사용자의 경험에 따라 그 유용성이 크게 차이날 수 있습니다. 사용자들은 DBT의 장점과 단점을 고려하여 프로젝트의 요구사항에 따라 적합한 도구를 선택해야 할 것입니다. 커뮤니티의 피드백을 통해 DBT를 더욱 잘 활용할 수 있는 방법이나 대안을 탐색하는 것이 중요합니다.

Top posts on r/dataengineering

Thoughts on DBT?

Releases

⭐️ Datahub v1.0.0

DataHub v1.0.0은 사용 편의성을 극대화한 새로운 UI와 데이터·AI 자산을 통합 관리할 수 있는 기능, 그리고 Iceberg 테이블 관리를 지원하는 업데이트로, 데이터 엔지니어들이 보다 효율적으로 메타데이터와 AI 파이프라인을 관리할 수 있게 해줍니다.

- 간소화된 탐색 기능과 시각적으로 멋진 인터페이스에 초점을 맞춰 완전히 새롭게 디자인된 사용자 경험을 제공합니다.

- AI 모델 그룹 버전, AI 모델 계보, 모델 통계, 실험/실행 수집을 포함한 데이터 및 AI에 대한 통합 지원을 제공합니다.

- DataHub Iceberg Catalog를 사용하면 사용자가 DataHub에서 직접 Iceberg 테이블을 관리할 수 있습니다.

Jobs

원티드 채용공고(최근 7일)

- 미리디 - 데이터 엔지니어

- 한국신용데이터(KCD) - [데이터플랫폼팀] Data Engineer

- 에스케이렌터카(SK렌터카) - Data Engineer (데이터 엔지니어)

- 인포유앤컴퍼니 - SQL 개발자

- 앰버로드 - Data Engineer

- 스카이월드와이드 - DB Engineer

- 콘센트릭스서비스코리아CATALYST - [Catalyst] 데이터엔지니어

- 브레이브모바일(숨고,Soomgo) - Data Engineer

- 한국신용데이터(KCD) - [장부팀] Data Scraping Engineer

- 위메이드(WEMADE) - DB운영 담당자

- 라이너(Liner) - Senior Data Engineer

- 퀀팃 - 금융 데이터 Ops 엔지니어

- 워트인텔리전스 - 데이터 엔지니어 (3년 이상)

- 휴톰 - Data Architect & Healthcare Data Engineer

- 베이글코드(Bagelcode) - [DATA&AI] Data Engineer(Platform)

- 바이오리서치에이아이 - 데이터엔지니어

- 현대오토에버 - [EnIT] Data Architect - SI 프로젝트

- 위메이드(WEMADE) - 데이터 엔지니어

- 현대오토에버 - [EnIT] Data Engineer - SAP BW / Qlik 운영

- 현대오토에버 - [SDx] Data Engineer - 스마트팩토리 데이터 수집 및 처리 (광명 소하)

- 콜로세움코퍼레이션 - 데이터분석엔지니어 (Data Analytics Engineer)

- 한국딥러닝 - 데이터 파이프라인 엔지니어

- 로이드케이 - 데이터 엔지니어 신입/주니어

- 에스투더블유(S2W) - Data Engineer (비웹수집 파이프라인)

- 에스투더블유(S2W) - Data Engineer (포트 스캐너 개발)

필요한 기술(최근 7일)

주요 업무(최근 7일)

필요한 소프트 스킬(최근 7일)

필요한 경험(최근 7일)

'데이터 엔지니어링 위클리' 카테고리의 다른 글

| 데이터 엔지니어링 위클리 #6 | Knowledge Graph, Data Observability, OpenTelemetry, OpenLineage (0) | 2025.04.08 |

|---|---|

| 데이터 엔지니어링 위클리 #5 | Shift Left, Karpenter, Data 3.0, Lakehouse (1) | 2025.04.01 |

| 데이터 엔지니어링 위클리 #4 | LLM, AI, Netflix, Airbnb (0) | 2025.03.26 |

| 데이터 엔지니어링 위클리 #2 | Data Lineage, SQLMesh, DBT, Synthetic Data (0) | 2025.03.11 |

| 데이터 엔지니어링 위클리 #1 | Medallion Architecture, Trino, LLM (0) | 2025.03.05 |